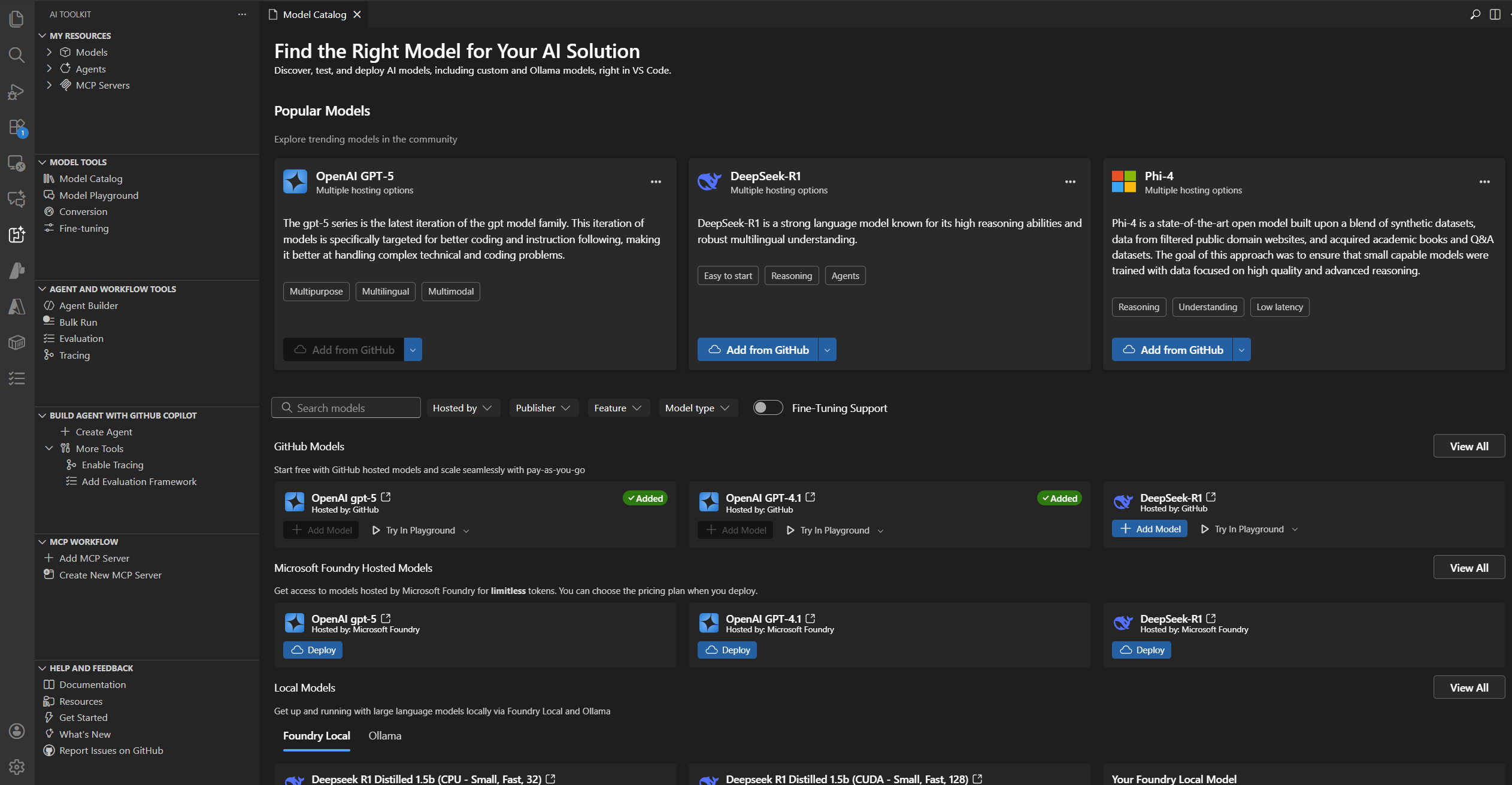

Modelle im AI Toolkit erkunden

Das AI Toolkit bietet umfassende Unterstützung für eine Vielzahl generativer KI-Modelle, einschließlich sowohl Small Language Models (SLMs) als auch Large Language Models (LLMs).

Innerhalb des Modellkatalogs können Sie Modelle aus mehreren Hosting-Quellen erkunden und nutzen

- Modelle, die auf GitHub gehostet werden, wie Llama3, Phi-3 und Mistral, einschließlich Pay-as-you-go-Optionen.

- Modelle, die direkt von Herausgebern bereitgestellt werden, einschließlich ChatGPT von OpenAI, Claude von Anthropic und Gemini von Google.

- Modelle, die auf Microsoft Foundry gehostet werden.

- Modelle, die lokal aus Repositories wie Ollama und ONNX heruntergeladen wurden.

- Benutzerdefinierte, selbst gehostete oder extern bereitgestellte Modelle, die über die Bring-Your-Own-Model (BYOM)-Integration zugänglich sind.

Stellen Sie Modelle direkt aus dem Modellkatalog in Foundry bereit und optimieren Sie so Ihren Workflow.

Verwenden Sie Microsoft Foundry, Foundry Local und GitHub-Modelle, die dem AI Toolkit mit GitHub Copilot hinzugefügt wurden. Weitere Informationen finden Sie unter Ändern des Modells für Chat-Konversationen.

Ein Modell finden

So finden Sie ein Modell im Modellkatalog

-

Wählen Sie die Ansicht AI Toolkit in der Aktivitätsleiste aus

-

Wählen Sie MODELLE > Katalog, um den Modellkatalog zu öffnen

-

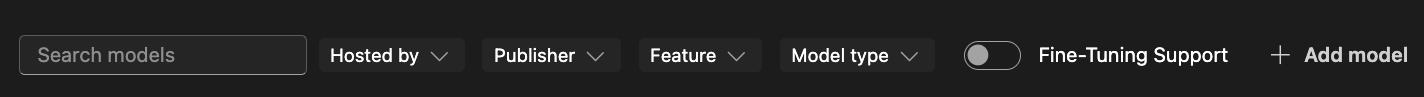

Verwenden Sie die Filter, um die Liste der verfügbaren Modelle einzugrenzen

- Gehostet von: AI Toolkit unterstützt GitHub, ONNX, OpenAI, Anthropic, Google als Modell-Hosting-Quellen.

- Herausgeber: Der Herausgeber der KI-Modelle, z. B. Microsoft, Meta, Google, OpenAI, Anthropic, Mistral AI und weitere.

- Funktion: Unterstützte Funktionen des Modells, wie z. B.

Textanhang,Bildanhang,Websuche,Strukturierte Ausgabenund mehr. - Modelltyp: Filtern Sie Modelle, die remote oder lokal auf CPU, GPU oder NPU ausgeführt werden können. Dieser Filter hängt von der lokalen Verfügbarkeit ab.

- Unterstützung für Fine-Tuning: Zeigen Sie Modelle an, die zum Ausführen von Fine-Tuning verwendet werden können.

-

Durchsuchen Sie die Modelle in verschiedenen Kategorien, wie z. B.

- Beliebte Modelle ist eine kuratierte Liste weit verbreiteter Modelle für verschiedene Aufgaben und Domänen.

- GitHub-Modelle bieten einfachen Zugriff auf beliebte Modelle, die auf GitHub gehostet werden. Dies ist am besten für schnelle Prototypen und Experimente geeignet.

- ONNX-Modelle sind für die lokale Ausführung optimiert und können auf CPU, GPU oder NPU ausgeführt werden.

- Ollama-Modelle sind beliebte Modelle, die lokal mit Ollama ausgeführt werden können und CPU über GGUF-Quantisierung unterstützen.

-

Alternativ können Sie die Suchleiste verwenden, um ein bestimmtes Modell nach Namen oder Beschreibung zu finden

Ein Modell aus dem Katalog hinzufügen

So fügen Sie ein Modell aus dem Modellkatalog hinzu

-

Suchen Sie das Modell, das Sie hinzufügen möchten, im Modellkatalog.

-

Wählen Sie Hinzufügen auf der Modellkarte

-

Der Ablauf zum Hinzufügen von Modellen unterscheidet sich geringfügig je nach Anbieter

-

GitHub: AI Toolkit fragt nach Ihren GitHub-Anmeldedaten, um auf das Modell-Repository zuzugreifen. Nach der Authentifizierung wird das Modell direkt in AI Toolkit hinzugefügt.

HinweisAI Toolkit unterstützt jetzt GitHub Pay-as-you-go-Modelle, sodass Sie auch nach Überschreitung der kostenlosen Freigrenzen weiterarbeiten können.

-

ONNX: Das Modell wird von ONNX heruntergeladen und zu AI Toolkit hinzugefügt.

-

Ollama: Das Modell wird von Ollama heruntergeladen und zu AI Toolkit hinzugefügt.

TippSie können den API-Schlüssel später bearbeiten, indem Sie mit der rechten Maustaste auf das Modell klicken und Bearbeiten auswählen. Den verschlüsselten Wert finden Sie in der Datei

${HOME}/.aikt/models/my-models/yml.

-

OpenAI, Anthropic und Google: AI Toolkit fordert Sie auf, den API-Schlüssel einzugeben.

-

Benutzerdefinierte Modelle: Detaillierte Anweisungen finden Sie im Abschnitt Ein benutzerdefiniertes Modell hinzufügen.

-

Nach dem Hinzufügen erscheint das Modell unter MEINE MODELLE in der Baumansicht und kann im Playground oder im Agent Builder verwendet werden.

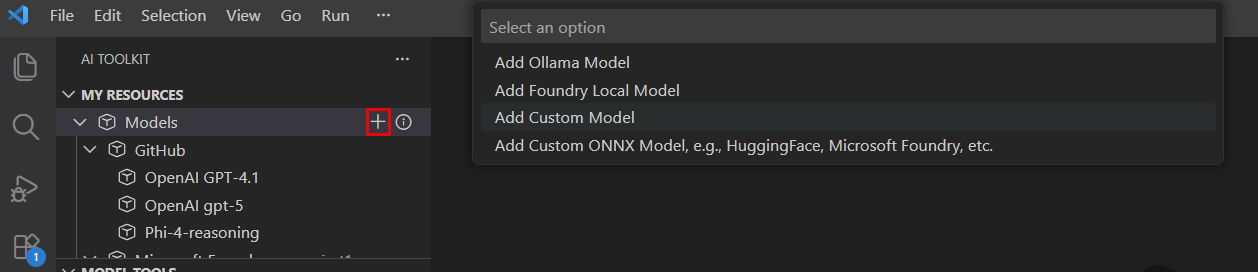

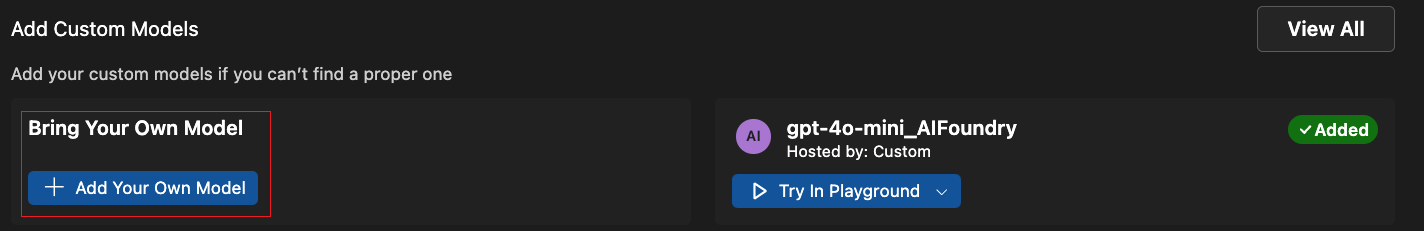

Ein benutzerdefiniertes Modell hinzufügen

Sie können auch eigene Modelle hinzufügen, die extern gehostet oder lokal ausgeführt werden. Hierfür stehen mehrere Optionen zur Verfügung

- Fügen Sie Ollama-Modelle aus der Ollama-Bibliothek oder benutzerdefinierten Ollama-Endpunkten hinzu.

- Fügen Sie benutzerdefinierte Modelle mit einem OpenAI-kompatiblen Endpunkt hinzu, z. B. ein selbst gehostetes Modell oder ein Modell, das auf einem Cloud-Dienst ausgeführt wird.

- Fügen Sie benutzerdefinierte ONNX-Modelle hinzu, z. B. von Hugging Face, mit dem Modellkonvertierungstool von AI Toolkit.

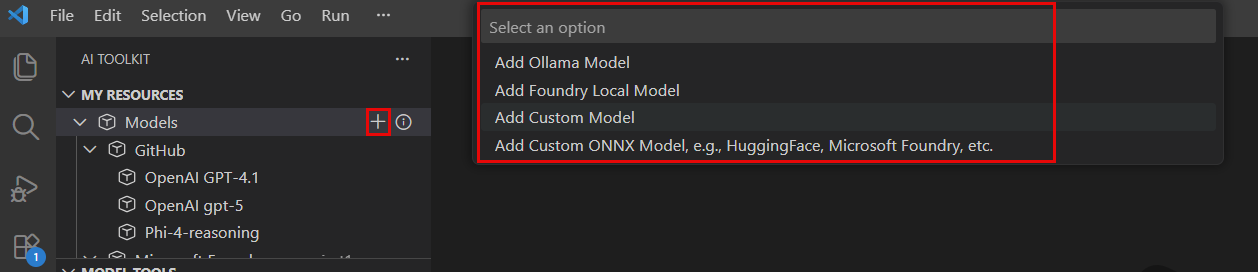

Es gibt mehrere Einstiegspunkte, um Modelle zu AI Toolkit hinzuzufügen

-

Wählen Sie unter MEINE MODELLE in der Baumansicht mit der Maus darüber und klicken Sie auf das

+Symbol.

-

Wählen Sie im Modellkatalog auf der Symbolleiste die Schaltfläche + Modell hinzufügen aus.

-

Wählen Sie im Abschnitt Benutzerdefinierte Modelle hinzufügen im Modellkatalog + Eigenes Modell hinzufügen aus.

Ollama-Modelle hinzufügen

Ollama ermöglicht die lokale Ausführung vieler beliebter GenAI-Modelle über CPU mittels GGUF-Quantisierung. Wenn Sie Ollama auf Ihrem lokalen Computer mit heruntergeladenen Ollama-Modellen installiert haben, können Sie diese zu AI Toolkit hinzufügen, um sie im Modell-Playground zu verwenden.

Voraussetzungen für die Verwendung von Ollama-Modellen in AI Toolkit

- AI Toolkit v0.6.2 oder neuer.

- Ollama (getestet mit Ollama v0.4.1)

Lokale Ollama-Modelle zu AI Toolkit hinzufügen

-

Wählen Sie über einen der oben genannten Einstiegspunkte Ollama-Modell hinzufügen.

-

Wählen Sie als Nächstes Modelle aus der Ollama-Bibliothek auswählen

Wenn Sie die Ollama-Laufzeitumgebung an einem anderen Endpunkt starten, wählen Sie Benutzerdefinierten Ollama-Endpunkt angeben, um einen Ollama-Endpunkt zu definieren.

-

Wählen Sie die Modelle aus, die Sie zu AI Toolkit hinzufügen möchten, und wählen Sie dann OK

HinweisAI Toolkit zeigt nur Modelle an, die bereits in Ollama heruntergeladen und noch nicht zu AI Toolkit hinzugefügt wurden. Um ein Modell von Ollama herunterzuladen, können Sie

ollama pull <modell-name>ausführen. Eine Liste der von Ollama unterstützten Modelle finden Sie in der Ollama-Bibliothek oder in der Ollama-Dokumentation. -

Sie sollten nun das/die ausgewählte(n) Ollama-Modell(e) in der Liste der Modelle in der Baumansicht sehen.

HinweisAnhänge werden für Ollama-Modelle noch nicht unterstützt. Da wir uns über den OpenAI-kompatiblen Endpunkt mit Ollama verbinden und dieser noch keine Anhänge unterstützt.

Ein benutzerdefiniertes Modell mit OpenAI-kompatiblem Endpunkt hinzufügen

Wenn Sie ein selbst gehostetes oder bereitgestelltes Modell haben, das über das Internet mit einem OpenAI-kompatiblen Endpunkt zugänglich ist, können Sie es zu AI Toolkit hinzufügen und im Playground verwenden.

- Wählen Sie über einen der oben genannten Einstiegspunkte Benutzerdefiniertes Modell hinzufügen.

- Geben Sie die URL des OpenAI-kompatiblen Endpunkts und die erforderlichen Informationen ein.

Ein selbst gehostetes oder lokal laufendes Ollama-Modell hinzufügen

- Wählen Sie im Modellkatalog + Modell hinzufügen.

- Wählen Sie im Modell-Quick-Pick Ollama oder Benutzerdefiniertes Modell.

- Geben Sie die erforderlichen Details zur Hinzufügung des Modells ein.

Ein benutzerdefiniertes ONNX-Modell hinzufügen

Um ein benutzerdefiniertes ONNX-Modell hinzuzufügen, konvertieren Sie es zuerst mit dem Modellkonvertierungstool in das AI Toolkit-Modellformat. Fügen Sie das Modell nach der Konvertierung zu AI Toolkit hinzu.

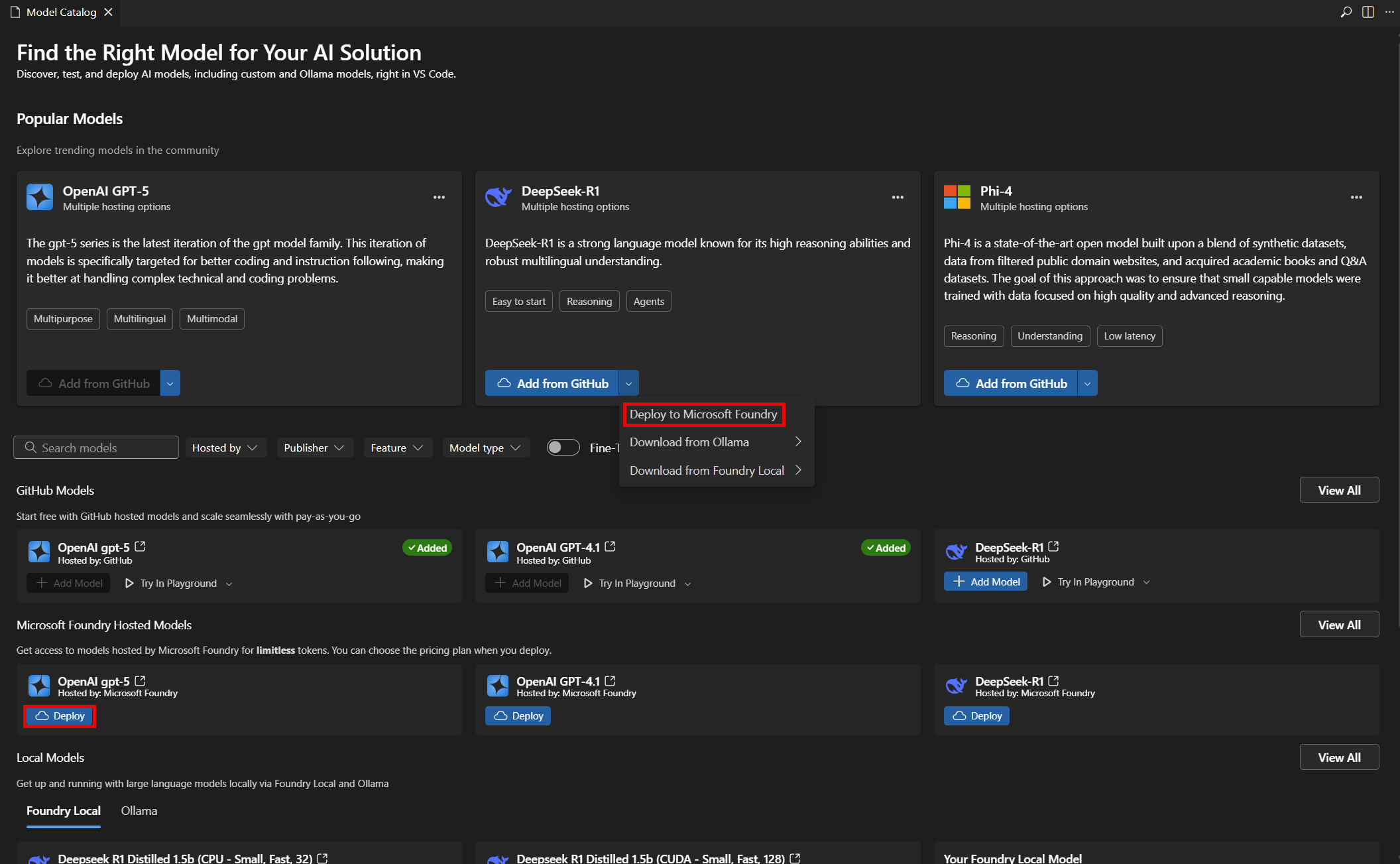

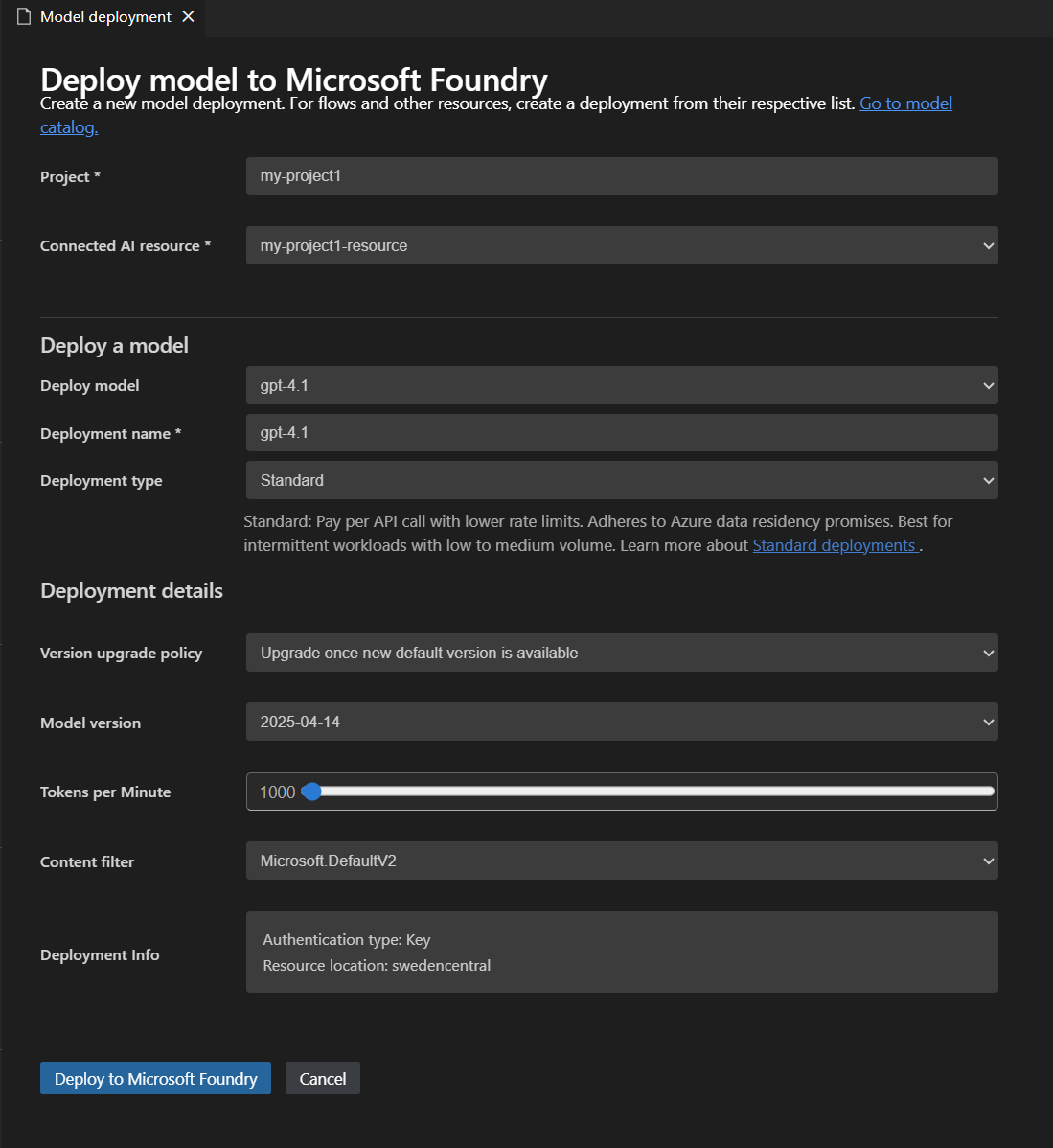

Ein Modell in Microsoft Foundry bereitstellen

Sie können ein Modell direkt aus dem AI Toolkit in Microsoft Foundry bereitstellen. Dies ermöglicht Ihnen, das Modell in der Cloud auszuführen und über einen Endpunkt darauf zuzugreifen.

-

Wählen Sie im Modellkatalog das Modell aus, das Sie bereitstellen möchten.

-

Wählen Sie In Microsoft Foundry bereitstellen, entweder über das Dropdown-Menü oder direkt über die Schaltfläche In Microsoft Foundry bereitstellen, wie im folgenden Screenshot dargestellt

-

Geben Sie im Tab Modellbereitstellung die erforderlichen Informationen ein, wie z. B. den Modellnamen, die Beschreibung und zusätzliche Einstellungen, wie im folgenden Screenshot dargestellt

-

Wählen Sie In Microsoft Foundry bereitstellen, um den Bereitstellungsprozess zu starten.

-

Ein Dialogfeld wird angezeigt, um die Bereitstellung zu bestätigen. Überprüfen Sie die Details und wählen Sie Bereitstellen, um fortzufahren.

-

Nach Abschluss der Bereitstellung ist das Modell im Abschnitt MEINE MODELLE des AI Toolkits verfügbar und kann im Playground oder Agent Builder verwendet werden.

Ein Modell zum Testen auswählen

Sie können ein Modell im Playground für Chat-Vervollständigungen testen.

Verwenden Sie die Aktionen auf der Modellkarte im Modellkatalog

- Im Playground ausprobieren: Lädt das ausgewählte Modell zum Testen in den Playground.

- Im Agent Builder ausprobieren: Lädt das ausgewählte Modell in den Agent Builder zum Erstellen von KI-Agenten.

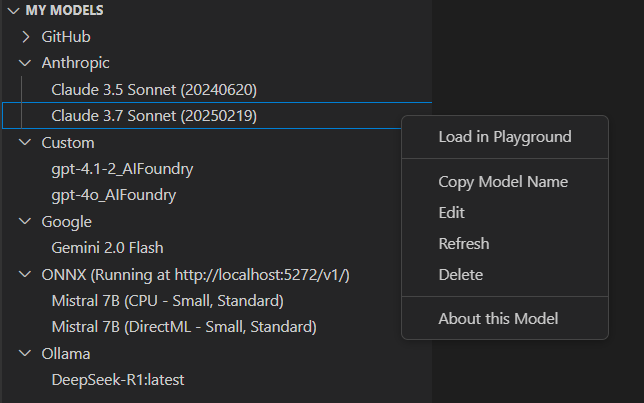

Modelle verwalten

Sie können Ihre Modelle im Abschnitt MEINE MODELLE der AI Toolkit-Ansicht verwalten. Hier können Sie

-

Die Liste der Modelle anzeigen, die Sie zu AI Toolkit hinzugefügt haben.

-

Klicken Sie mit der rechten Maustaste auf ein Modell, um Optionen wie z. B. aufzurufen

- Im Playground laden: Lädt das Modell in den Playground zum Testen.

- Modellnamen kopieren: Kopiert den Modellnamen in die Zwischenablage zur Verwendung in anderen Kontexten, z. B. in Ihrer Code-Integration.

- Aktualisieren: Aktualisiert die Modellkonfiguration, um sicherzustellen, dass Sie die neuesten Einstellungen haben.

- Bearbeiten: Ändert die Modelleinstellungen, z. B. den API-Schlüssel oder den Endpunkt.

- Löschen: Entfernt das Modell aus AI Toolkit.

- Über dieses Modell: Zeigt detaillierte Informationen über das Modell an, einschließlich Herausgeber, Quelle und unterstützter Funktionen.

-

Klicken Sie mit der rechten Maustaste auf den Titel des Abschnitts

ONNX, um Optionen wie z. B. aufzurufen- Server starten: Startet den ONNX-Server zum lokalen Ausführen von ONNX-Modellen.

- Server stoppen: Stoppt den ONNX-Server, falls er ausgeführt wird.

- Endpunkt kopieren: Kopiert den ONNX-Server-Endpunkt in die Zwischenablage zur Verwendung in anderen Kontexten, z. B. in Ihrer Code-Integration.

Lizenz und Anmeldung

Einige Modelle erfordern eine Lizenz und ein Konto des Herausgebers oder Hosting-Dienstes zur Anmeldung. In diesem Fall werden Sie aufgefordert, diese Informationen anzugeben, bevor Sie das Modell im Modell-Playground ausführen können.

Was Sie gelernt haben

In diesem Artikel haben Sie gelernt, wie Sie

- Generative KI-Modelle in AI Toolkit erkunden und verwalten.

- Modelle aus verschiedenen Quellen finden, darunter GitHub, ONNX, OpenAI, Anthropic, Google, Ollama und benutzerdefinierte Endpunkte.

- Modelle zu Ihrem Toolkit hinzufügen und sie in Microsoft Foundry bereitstellen.

- Benutzerdefinierte Modelle, einschließlich Ollama- und OpenAI-kompatibler Modelle, hinzufügen und im Playground oder Agent Builder testen.

- Den Modellkatalog verwenden, um verfügbare Modelle anzuzeigen und die beste Option für die Anforderungen Ihrer KI-Anwendung auszuwählen.

- Filter und Suche verwenden, um Modelle schnell zu finden.

- Modelle nach Kategorien durchsuchen, wie z. B. Beliebt, GitHub, ONNX und Ollama.

- Benutzerdefinierte ONNX-Modelle konvertieren und hinzufügen, indem das Modellkonvertierungstool verwendet wird.

- Modelle in MEINE MODELLE verwalten, einschließlich Bearbeiten, Löschen, Aktualisieren und Anzeigen von Details.

- Den ONNX-Server starten und stoppen und Endpunkte für lokale Modelle kopieren.

- Lizenz- und Anmeldeanforderungen für einige Modelle erfüllen, bevor Sie diese testen.