KI-Toolkit FAQ

Modelle

Wie finde ich meinen Remote-Modellendpunkt und den Authentifizierungsheader?

Hier sind einige Beispiele, wie Sie Ihren Endpunkt und Ihre Authentifizierungsheader bei gängigen OpenAI-Dienstanbietern finden können. Für andere Anbieter können Sie deren Dokumentation zum Chat-Vervollständigungsendpunkt und Authentifizierungsheader konsultieren.

Beispiel 1: Azure OpenAI

-

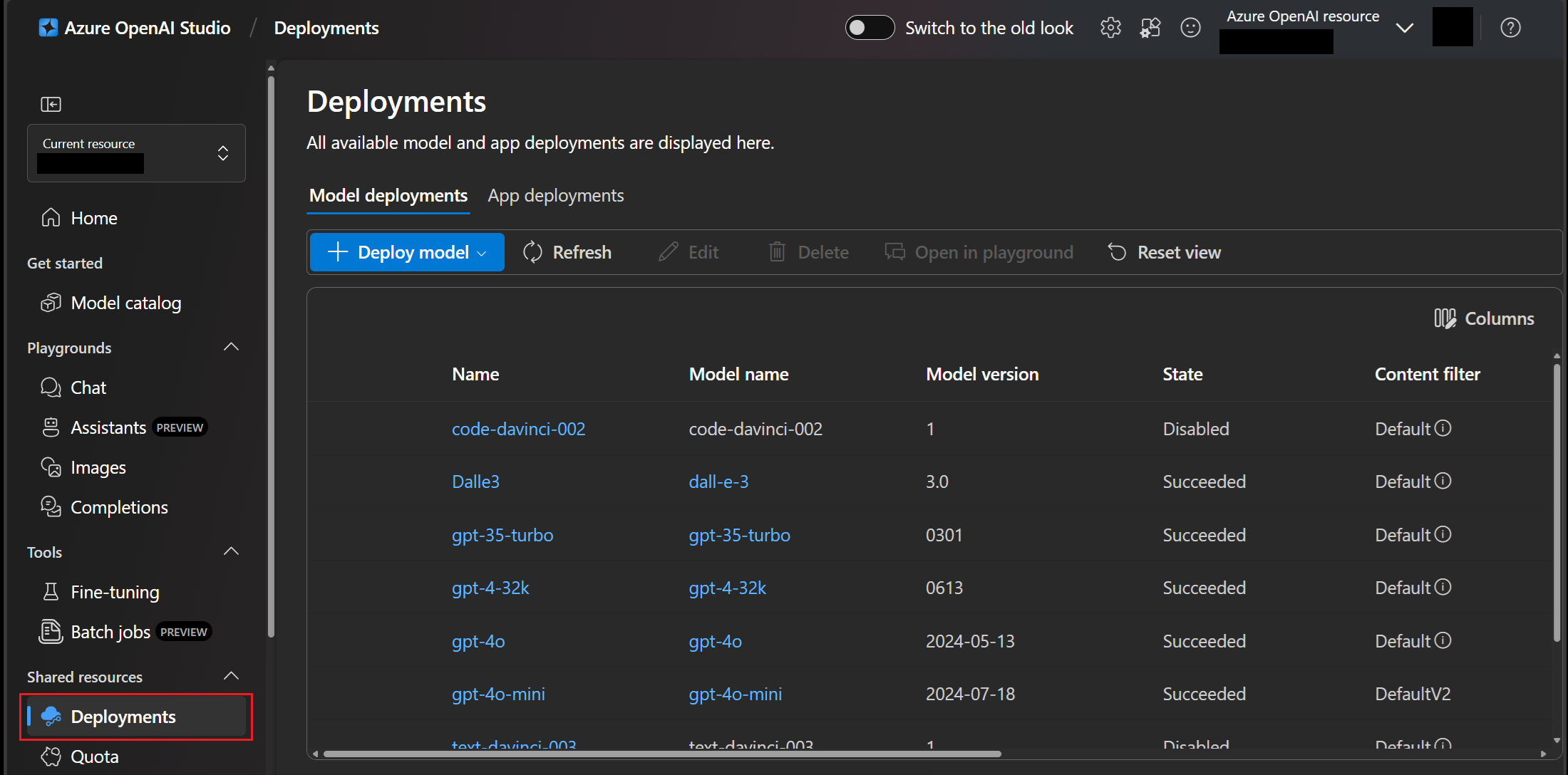

Gehen Sie zum Blade Bereitstellungen im Azure OpenAI Studio und wählen Sie eine Bereitstellung aus, z. B.

gpt-4o. Wenn Sie noch keine Bereitstellung haben, lesen Sie die Azure OpenAI-Dokumentation, um zu erfahren, wie Sie eine Bereitstellung erstellen.

-

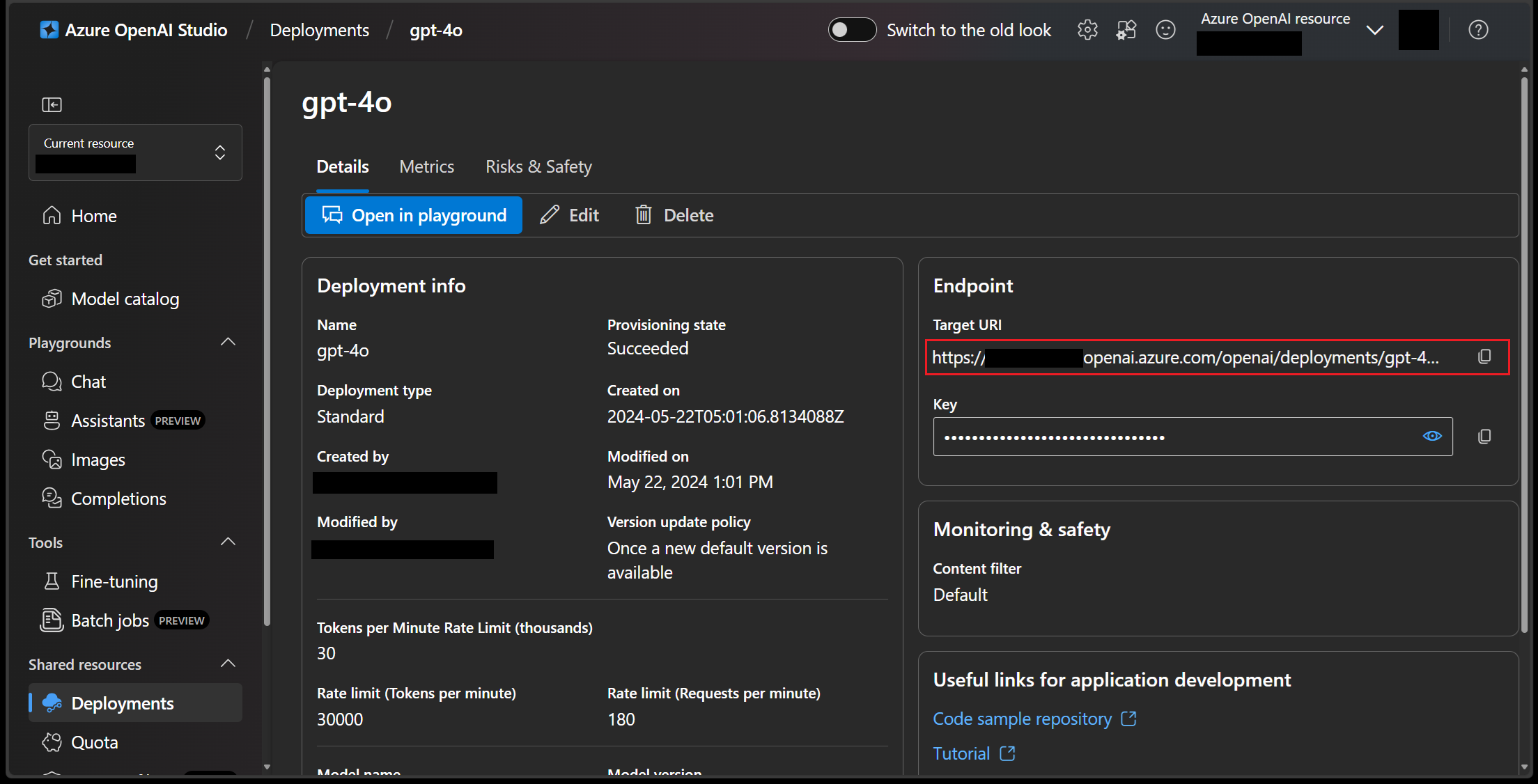

Rufen Sie Ihren Chat-Vervollständigungsendpunkt im Feld Ziel-URI im Abschnitt Endpunkt ab

-

Rufen Sie den API-Schlüssel aus der Eigenschaft Schlüssel im Abschnitt Endpunkt ab.

Nachdem Sie den API-Schlüssel kopiert haben, fügen Sie ihn im Format

api-key: <IHR_API_SCHLÜSSEL>für den Authentifizierungsheader im KI-Toolkit hinzu. Weitere Informationen zum Authentifizierungsheader finden Sie in der Azure OpenAI-Dienstdokumentation.

Beispiel 2: OpenAI

-

Der Chat-Vervollständigungsendpunkt ist derzeit auf

https://api.openai.com/v1/chat/completionsfestgelegt. Weitere Informationen finden Sie in der OpenAI-Dokumentation. -

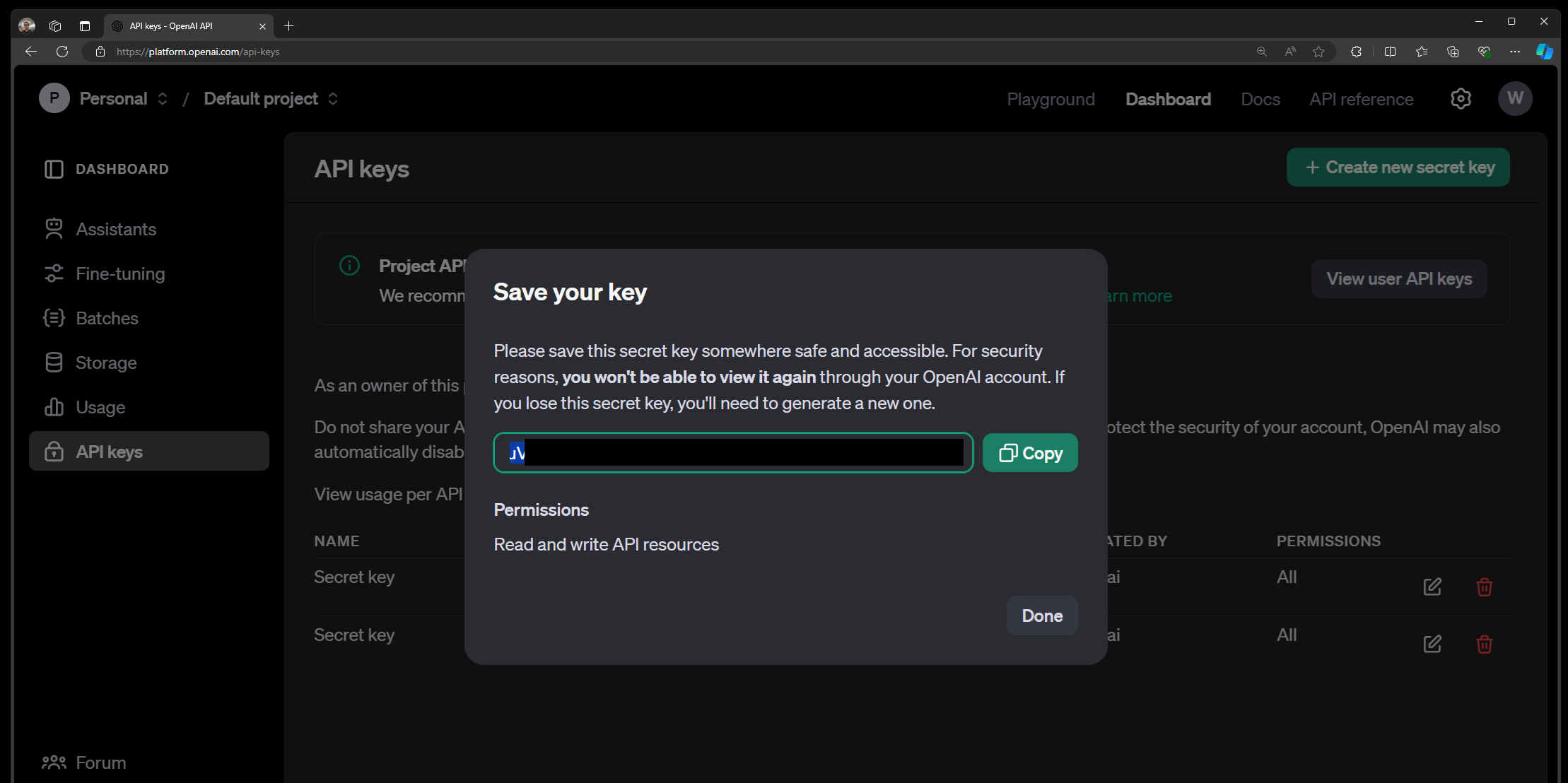

Gehen Sie zur OpenAI-Dokumentation und wählen Sie

API-SchlüsseloderProjekt-API-Schlüsselaus, um Ihren API-Schlüssel zu erstellen oder abzurufen.Nachdem Sie den API-Schlüssel kopiert haben, geben Sie ihn im Format

Authorization: Bearer <IHR_API_SCHLÜSSEL>für den Authentifizierungsheader im KI-Toolkit ein. Weitere Informationen finden Sie in der OpenAI-Dokumentation.

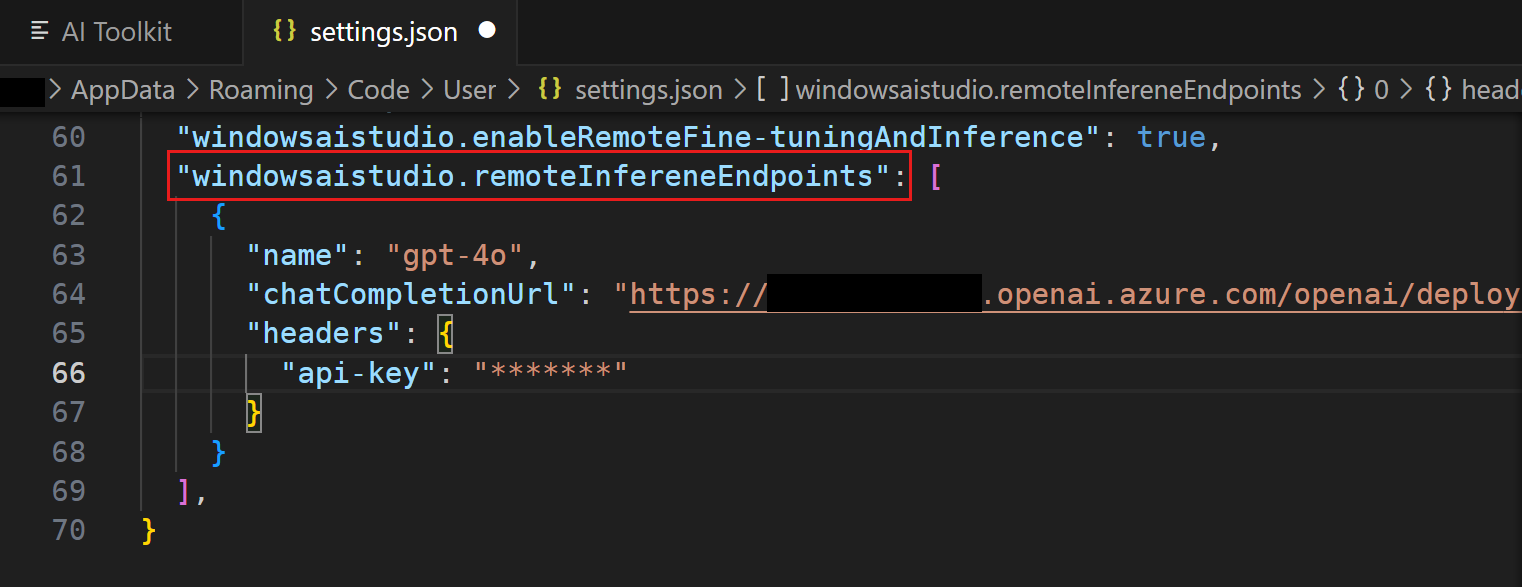

Wie bearbeite ich die Endpunkt-URL oder den Authentifizierungsheader?

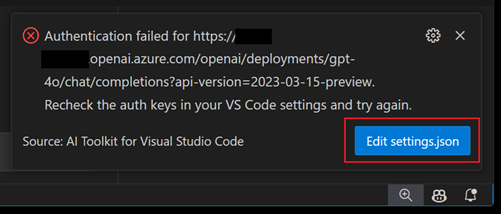

Wenn Sie den falschen Endpunkt oder Authentifizierungsheader eingeben, kann es zu Fehlern bei der Inferenz kommen.

-

Öffnen Sie die VS Code-Datei

setting.json-

Wählen Sie

settings.json bearbeitenin der Benachrichtigung über Authentifizierungsfehler aus

-

Alternativ geben Sie

Benutzereinstellungen öffnen (JSON)in der Befehlspalette ein (⇧⌘P (Windows, Linux Ctrl+Shift+P))

-

-

Suchen Sie nach der Einstellung

windowsaistudio.remoteInfereneEndpoints -

Bearbeiten oder entfernen Sie vorhandene Endpunkt-URLs oder Authentifizierungsheader.

Nachdem Sie die Einstellungen gespeichert haben, wird die Modellliste in der Baumansicht oder im Playground automatisch aktualisiert.

Wie kann ich mich für die Warteliste für OpenAI o1-mini oder OpenAI o1-preview anmelden?

Die OpenAI-Modelle der o1-Serie sind speziell darauf ausgelegt, Argumentations- und Problemlösungsaufgaben mit erhöhter Konzentration und Leistungsfähigkeit zu bewältigen. Diese Modelle verbringen mehr Zeit mit der Verarbeitung und dem Verständnis der Benutzeranfragen, was sie in Bereichen wie Wissenschaft, Programmierung, Mathematik und ähnlichen Feldern außergewöhnlich stark macht. Beispielsweise kann o1 von Gesundheitsforschern zur Annotation von Zellsequenzierungsdaten, von Physikern zur Erzeugung komplexer mathematischer Formeln für die Quantenoptik und von Entwicklern in allen Bereichen zum Aufbau und zur Ausführung mehrstufiger Arbeitsabläufe verwendet werden.

Das o1-preview-Modell ist für eingeschränkten Zugriff verfügbar. Um das Modell im Playground auszuprobieren, ist eine Registrierung erforderlich, und der Zugriff wird auf Grundlage der Microsoft-Zugangskriterien gewährt.

Besuchen Sie den GitHub-Modellmarkt, um OpenAI o1-mini oder OpenAI o1-preview zu finden und sich für die Warteliste anzumelden.

Kann ich meine eigenen Modelle oder andere Modelle von Hugging Face verwenden?

Wenn Ihr eigenes Modell den OpenAI API-Vertrag unterstützt, können Sie es in der Cloud hosten und das Modell als benutzerdefiniertes Modell zum KI-Toolkit hinzufügen. Sie müssen wichtige Informationen wie Modellendpunkt-URL, Zugriffsschlüssel und Modellname angeben.

Feinabstimmung

Es gibt viele Einstellungen für die Feinabstimmung. Muss ich mich um alle kümmern?

Nein, Sie können die Standardeinstellungen und unseren Beispieldatensatz zum Testen verwenden. Sie können auch Ihren eigenen Datensatz auswählen, müssen dann aber einige Einstellungen anpassen. Weitere Informationen finden Sie im Feinabstimmungs-Tutorial.

Das KI-Toolkit erstellt kein Gerüst für das Feinabstimmungsprojekt

Stellen Sie sicher, dass Sie die Erweiterungsvoraussetzungen überprüfen, bevor Sie die Erweiterung installieren.

Ich habe ein NVIDIA GPU-Gerät, aber die Voraussetzungsprüfung schlägt fehl

Wenn Sie ein NVIDIA GPU-Gerät haben, aber die Voraussetzungsprüfung mit der Meldung "GPU wird nicht erkannt" fehlschlägt, stellen Sie sicher, dass der neueste Treiber installiert ist. Sie können den Treiber auf der NVIDIA-Website überprüfen und herunterladen.

Stellen Sie außerdem sicher, dass er im Pfad installiert ist. Zur Überprüfung führen Sie nvidia-smi in der Befehlszeile aus.

Ich habe das Projekt generiert, aber Conda Activate kann die Umgebung nicht finden

Möglicherweise gab es ein Problem beim Einrichten der Umgebung. Sie können die Umgebung manuell initialisieren, indem Sie bash /mnt/[PROJEKT_PFAD]/setup/first_time_setup.sh von innerhalb des Arbeitsbereichs aus verwenden.

Wenn ich einen Hugging Face-Datensatz verwende, wie bekomme ich ihn?

Bevor Sie den Befehl python finetuning/invoke_olive.py ausführen, stellen Sie sicher, dass Sie den Befehl huggingface-cli login ausführen. Dies stellt sicher, dass der Datensatz in Ihrem Namen heruntergeladen werden kann.

Umgebung

Funktioniert die Erweiterung unter Linux oder anderen Systemen?

Ja, das KI-Toolkit läuft unter Windows, Mac und Linux.

Wie kann ich die Conda-Autoaktivierung von meinem WSL deaktivieren?

Um die Conda-Installation in WSL zu deaktivieren, führen Sie conda config --set auto_activate_base false aus. Dies deaktiviert die Basisumgebung.

Unterstützen Sie derzeit Container?

Wir arbeiten derzeit an der Containerunterstützung, die in einer zukünftigen Version verfügbar sein wird.

Warum benötigen Sie GitHub- und Hugging Face-Zugangsdaten?

Wir hosten alle Projektvorlagen auf GitHub, und die Basismodelle werden in Azure oder Hugging Face gehostet. Diese Umgebungen erfordern ein Konto, um von den APIs darauf zugreifen zu können.

Ich erhalte einen Fehler beim Herunterladen von Llama2

Stellen Sie sicher, dass Sie den Zugriff auf Llama über die Llama 2-Anmeldeseite anfordern. Dies ist erforderlich, um die Handelsbestimmungen von Meta einzuhalten.

Ich kann kein Projekt innerhalb der WSL-Instanz speichern

Da Remote-Sitzungen derzeit nicht unterstützt werden, wenn KI-Toolkit-Aktionen ausgeführt werden, können Sie Ihr Projekt nicht speichern, während Sie mit WSL verbunden sind. Um Remote-Verbindungen zu schließen, wählen Sie "WSL" unten links auf dem Bildschirm aus und wählen Sie "Remote-Verbindungen schließen".

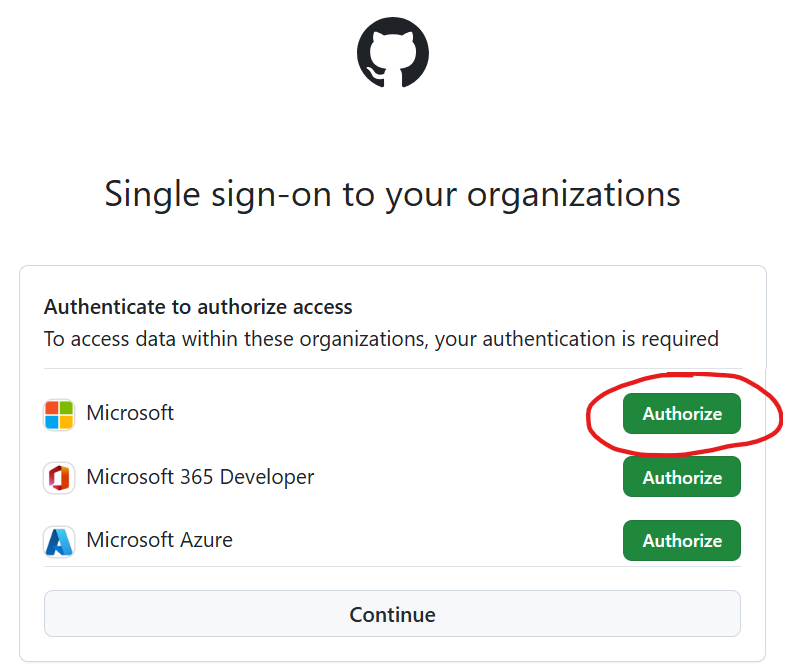

Fehler: GitHub API verboten

Wir hosten die Projektvorlagen im GitHub-Repository microsoft/windows-ai-studio-templates, und die Erweiterung verwendet die GitHub-API, um die Repository-Inhalte zu laden. Wenn Sie sich bei Microsoft befinden, müssen Sie möglicherweise die Microsoft-Organisation autorisieren, um solche verbotenen Probleme zu vermeiden.

Sehen Sie sich dieses Problem für eine Problemumgehung an. Die detaillierten Schritte sind:

-

Melden Sie sich von GitHub in VS Code ab

-

Laden Sie VS Code und KI-Toolkit neu und Sie werden erneut aufgefordert, sich bei GitHub anzumelden

-

Wichtig: Stellen Sie auf der Autorisierungsseite im Browser sicher, dass Sie die App zur Nutzung der Microsoft-Organisation autorisieren

Kann ONNX-Modelle nicht auflisten, laden oder herunterladen

Überprüfen Sie das KI-Toolkit-Protokoll im VS Code-Ausgabefenster. Wenn Sie Agent-Fehler oder Heruntergeladene Modelle konnten nicht abgerufen werden sehen, schließen Sie alle VS Code-Instanzen und öffnen Sie VS Code erneut.

(Dieses Problem wird durch den unerwarteten Absturz des zugrunde liegenden ONNX-Agenten verursacht. Der obige Schritt dient zum Neustart des Agenten.)