Erweiterung der Modellauswahl in VS Code mit "Bring Your Own Key"

22. Oktober 2025 von Olivia Guzzardo McVicker, Pierce Boggan

Wir wissen, dass die Modellauswahl für Sie wichtig ist. Unser Team hat hart daran gearbeitet, die neuesten Modelle wie Claude Haiku 4.5 und GPT 5 am selben Tag verfügbar zu machen, an dem sie angekündigt wurden. Aber wir haben auch Ihr Feedback gehört, dass Sie sich in VS Code Unterstützung für noch mehr Modelle wünschen, sei es lokal oder in der Cloud.

Im März haben wir die Funktion "Bring Your Own Key" (BYOK) veröffentlicht, mit der Sie aus Hunderten von Modellen von unterstützten Anbietern wie OpenRouter, Ollama, Google, OpenAI und mehr auswählen können, um Chat-Erlebnisse in VS Code zu ermöglichen.

Jetzt bringen wir BYOK auf die nächste Stufe. In der v1.104-Version haben wir die Language Model Chat Provider API eingeführt, die es Modell-Anbietern ermöglicht, ihre Modelle direkt über VS Code-Erweiterungen beizusteuern.

Was ist "Bring Your Own Key" (BYOK)?

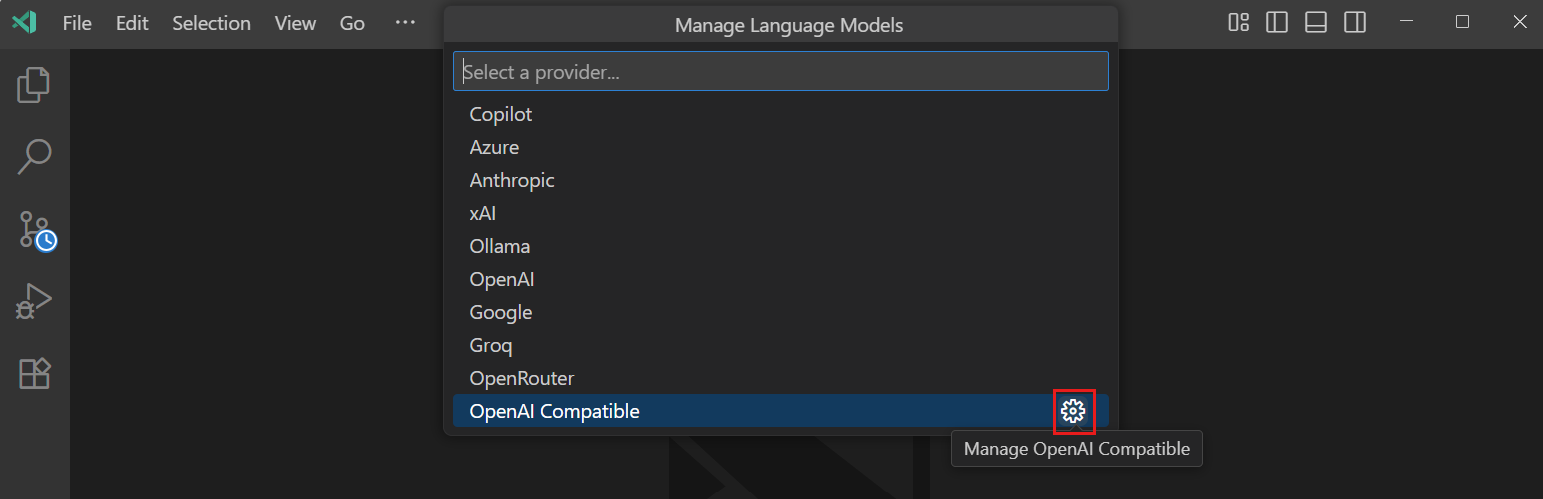

BYOK ermöglicht es Ihnen, jedes Modell von einem unterstützten Anbieter zu verwenden, indem Sie Ihren eigenen API-Schlüssel für diesen Anbieter mitbringen. Das bedeutet, dass Sie auf ein riesiges Ökosystem von Modellen zugreifen können, das über die in VS Code integrierten hinausgeht. Ob Sie ein spezialisiertes Modell für die Code-Generierung, ein anderes Modell für den allgemeinen Chat oder lokale Modelle über Anbieter wie Ollama ausprobieren möchten, BYOK macht es mit Ihrem API-Schlüssel möglich. Sie können dies über den Befehl Chat: Language Models verwalten konfigurieren.

Die Verwaltung einer ständig wachsenden Liste von unterstützten Anbietern stellte jedoch sowohl für Benutzer als auch für unser Team Herausforderungen dar. Deshalb haben wir die Language Model Chat Provider API veröffentlicht, die es Modell-Anbietern ermöglicht, ihre Modelle direkt über VS Code-Erweiterungen beizusteuern.

Die Language Model Chat Provider API

Die Language Model Chat Provider API verlagert BYOK von einem zentralisierten System zu einem offenen, erweiterbaren Ökosystem, in dem jeder Anbieter seine Modelle mit einer einfachen Erweiterungsinstallation anbieten kann. Wir werden weiterhin eine Teilmenge der integrierten Anbieter unterstützen, aber dieses erweiterbare Ökosystem wird es uns ermöglichen, unsere Modellauswahl zu skalieren, um die Bedürfnisse der Entwickler zu erfüllen.

Modelle, die über die Language Model Chat Provider API bereitgestellt werden, sind derzeit für Benutzer mit einzelnen GitHub Copilot-Plänen (Free, Pro und Pro+) verfügbar.

Hier sind einige unserer Lieblingserweiterungen, die Sie jetzt installieren können, um in VS Code auf mehr Modelle zuzugreifen

-

Die Erweiterung "AI Toolkit for Visual Studio Code" bietet Ihnen direkten Zugriff auf die von ihr bereitgestellten Modelle in VS Code, sei es ein benutzerdefiniertes Modell, das Sie in Azure AI Foundry optimiert haben, ein lokales Modell über Foundry Local oder eines der Modelle in GitHub Models.

-

Cerebras Inference treibt die weltweit besten Coding-Modelle an und macht die Code-Generierung nahezu sofortig, was großartig für schnelle Iterationen ist. Es führt Qwen3 Coder und GPT OSS 120B mit 2.000 Tokens/s aus, was 20x schneller ist als die meisten Inferenz-APIs.

-

Die Erweiterung "Hugging Face Provider for GitHub Copilot Chat" ermöglicht es Ihnen, die modernsten Open LLMs wie Kimi K2, DeepSeek V3.1, GLM 4.5 direkt in VS Code zu verwenden. Die Inference-Anbieter von Hugging Face bieten Entwicklern Zugriff auf Hunderte von LLMs, unterstützt von erstklassigen Inferenz-Anbietern, die für hohe Verfügbarkeit und niedrige Latenz entwickelt wurden.

Für Erweiterungsentwickler, die daran interessiert sind, ihre eigenen Modelle beizusteuern, werfen Sie einen Blick auf unsere Dokumentation zur Language Model Chat Provider API und unser Beispiel-Erweiterung, um noch heute mit der Entwicklung zu beginnen.

OpenAI-kompatible Modelle

Für Entwickler, die OpenAI-kompatible Modelle verwenden, können Sie den benutzerdefinierten Anbieter "OpenAI Compatible" für jeden OpenAI-kompatiblen API-Endpunkt verwenden und die Modelle für die Chat-Nutzung konfigurieren. Diese Funktion ist derzeit nur in VS Code Insiders verfügbar.

Zusätzlich können Sie die Liste der Editierwerkzeuge explizit über die Einstellung github.copilot.chat.customOAIModels konfigurieren, was Ihnen eine detaillierte Kontrolle über die verfügbaren Funktionen für Ihre benutzerdefinierten Modelle gibt.

Was kommt als Nächstes?

Die Language Model Chat Provider API ist erst der Anfang, um Ihnen mehr Modellauswahl zu bieten. Mit wachsendem Ökosystem erwarten wir

- eine Benutzeroberfläche für die Modellverwaltung, die es Ihnen ermöglicht, sich über Modellfähigkeiten zu informieren und Modelle zu verwalten

- einen reibungsloseren Ablauf für die Installation von Erweiterungen, die Sprachmodelle beisteuern

- Verbesserungen an den integrierten Anbietern von Sprachmodellen, die Nutzung der neuesten Anbieter-APIs und die Bereitstellung spezialisierter Prompts je nach Modell

Wir investieren kontinuierlich in die BYOK-Erfahrung. Aktuelle Verbesserungen umfassen verbesserte Editierwerkzeuge für eine bessere Integration mit den integrierten Werkzeugen von VS Code, aber wir wissen, dass noch Arbeit zu tun ist, um die Erfahrung besser in VS Code zu integrieren - BYOK funktioniert zum Beispiel derzeit nicht mit Completions. Wir freuen uns über Ihr Feedback in unserem GitHub-Repository!

Viel Spaß beim Codieren!